# Nginx教程 - 11 负载均衡配置

负载均衡就是当我们的服务器接收到的请求太多,压力太大,此时可能导致服务器性能下降或不可用,为了解决这个问题,我们可以搭建多台服务器,将请求分配到多个服务器上进行处理,从而保证服务的可用性,即使有服务器挂掉,服务也能正常运行,通过负载均衡,我们可以动态的增加或减少服务器的数量,增强网站的可扩展性,这样也利于我们更新服务。

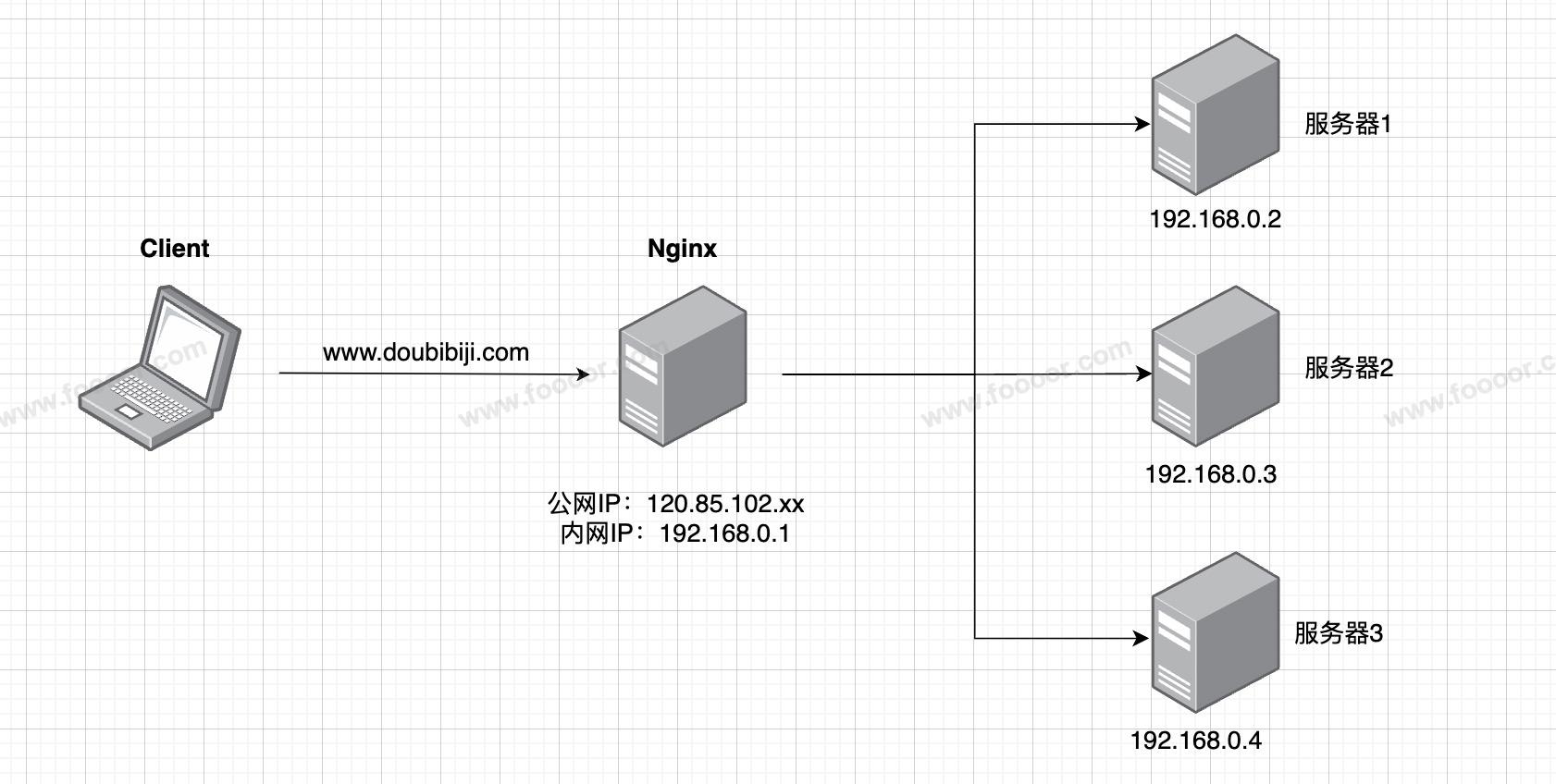

而 Nginx 作为一款高性能的 Web 服务器和反向代理服务器,可以通过其负载均衡功能,将接收到的客户端请求,根据配置的负载均衡策略(如轮询、最少连接、IP哈希等)转发给多个后端服务器,从而实现负载均衡。

Nginx 负载均衡主要有四层和七层负载均衡。

# 11.1 七层负载均衡配置

下面介绍一下 Nginx 实现的七层负载均衡,需要使用 proxy_pass 代理模块,通过反向代理,将请求转发到一组upstream虚拟服务池。

在上图中,Nginx 将请求转发给集群的多台服务器上(服务器1/2/3),这里为了演示方便,直接使用三个 Nginx 的 server 来充当三台服务器。

Nginx 配置如下:

内容未完......